Alors que les débats postmodernes battaient leur plein, au moins un critique aux États-Unis remarqua le lien qui existait entre le pastiche et l’informatisation. Dans son ouvrage After the Great Divide (1986), Andreas Huyssen écrivit :

« Toutes les techniques, les formes et les images modernes et avant-gardistes sont à présent stockées dans les banques de données de notre culture, accessibles à tout instant. Mais cette même mémoire englobe également tout l’art prémoderne, ainsi que les genres, les codes et les univers picturaux des cultures populaires et de la culture de masse moderne11 Andreas Huyssen, « Mapping the Postmodern », After the Great Divide, Bloomington et Indianapolis, Indiana University Press, 1986, p. 196.. »

Son analyse est exacte — sauf que ces « banques de données informatisées » n’allaient pas devenir monnaie courante avant une quinzaine d’années. Ce n’est qu’après que le Web ait absorbé suffisamment d’archives médias qu’il se transforma en cette banque de données universelle, accessible à tous les producteurs culturels. Mais même pour les professionnels, la capacité à facilement intégrer de nombreuses sources médias au sein d’un même projet — calques vidéo, images fixes scannées, animation, graphisme et typographie — ne se répandit qu’à la fin des années 1990.

En 1985, lorsque l’ouvrage de Huyssen était en préparation, je travaillais pour Digital Effects22 Voir : Wayne Carlson, A Critical History of Computer Graphics and Animations, Section 2: The Emergence of Computer Graphics Technology., une des seules entreprises d’animation par ordinateur. Chaque animateur avait son propre terminal graphique interactif qui pouvait afficher des modèles 3D, mais seulement en filaire monochrome ; pour avoir un rendu complet en couleur, chacun devait attendre son tour car l’entreprise n’avait qu’un seul écran couleur. Les données étaient stockées sur de grosses bandes magnétiques d’environ trente centimètres de diamètre. Retrouver les données d’un ancien projet était ainsi un processus fastidieux qui impliquait de débusquer la bonne bande dans la réserve, de la consulter à l’aide d’un lecteur de bandes magnétiques, puis de chercher le bon passage sur la bande. Nous n’avions pas de scanner couleur, ce qui fait qu’incorporer « toutes les techniques, les formes et les images modernes et avant-gardistes » dans l’ordinateur n’était pas une mince affaire. Même si nous en avions eu un, il n’y avait aucun moyen de stocker ces images, ni d’y accéder ou de les modifier. La seule machine qui en était capable, la Quantel Paintbox, coûtait plus de 160 000 dollars — une somme que nous ne pouvions pas nous permettre de dépenser. Et lorsqu’en 1986, Quantel présenta Harry, le premier système de montage non linéaire commercial à permettre la composition numérique (compositing) de nombreuses couches de vidéos et d’effets spéciaux, son coût prohibitif le rendit inaccessible pour tous, à l’exception des chaînes de télévision et de quelques maisons de production. Harry ne pouvait enregistrer que 80 secondes de vidéo de qualité broadcast. Pour les images fixes, la situation n’était guère meilleure : Picturebox, le système de dépôt d’images numériques lancé par Quantel en 1990, ne pouvait par exemple contenir que 500 images broadcast et son coût était, lui aussi, très élevé.

En somme, au milieu des années 1980, ni Digital Effects ni aucune autre société de production ne possédait quoi que ce soit qui ressemble aux « banques de données informatisées » qu’imaginait Huyssen. Il en allait évidemment de même pour les artistes visuels associés au postmodernisme qui cultivaient les concepts de pastiche, de collage et d’appropriation. En 1986, la BBC produisit un documentaire, Painting with Light (Peindre avec la lumière)33 Painting with Light est un documentaire réalisé par la BBC en 1986 présentant David Hockney dessinant en direct sur une Paintbox, http://b-o.fr/hockney, dans lequel la chaîne proposa à une demi-douzaine de peintres célèbres, dont Richard Hamilton et David Hockney de travailler avec la Quantel Paintbox. Les images qui en résultèrent ne différaient guère de celles que ces artistes produisaient sans ordinateur. Bien que certaines d’entre elles fassent référence aux « techniques, [aux] formes et [aux] images modernes et avant-gardistes », ces références étaient peintes plutôt que directement téléchargées depuis des « banques de données informatisées ». Au milieu des années 1990, les stations de travail graphique relativement bon marché et les ordinateurs personnels dotés de logiciels de retouche, d’animation, de compositing (composition) et d’illustration se répandirent, devenus abordables pour les designers graphiques et les illustrateurs indépendants, ainsi que pour les petits studios de postproduction et d’animation. Ce n’est qu’à ce moment-là que la situation décrite par Huyssen commença à devenir réalité. Les résultats furent spectaculaires : en l’espace de cinq ans environ, la culture visuelle contemporaine fut profondément transformée. Des médias autrefois distincts — le cinéma, le design graphique, la photographie, l’animation, l’animation 3D par ordinateur et la typographie — commencèrent à être conjugués de différentes manières. À la fin des années 1990, le média de la « pure » image en mouvement était devenu une exception, et le média hybride, la norme. […]

Hybridité visuelle

[…] Aujourd’hui (en 2006), le nouveau langage hybride des images en mouvement qui a émergé entre 1993 et 1998 domine notre culture visuelle. Les productions narratives se cantonnent le plus souvent à la prise de vue réelle et les vidéos réalisées par des particuliers avec des caméscopes grand public ou des téléphones portables sont elles aussi généralement laissées telles quelles. Quant au reste — publicités, clips musicaux, animation graphique, graphisme télévisé, et toute autre forme de film court non narratif ou de séquences d’images en mouvement produites par les professionnels du monde entier (entreprises, designers et artistes indépendants ou étudiants) — tout est hybride. […]

Aujourd’hui, l’ubiquité de ce nouveau langage visuel hybride est telle qu’essayer de se souvenir de l’aspect antérieur des choses demande un effort. De même, les mutations au sein des processus de production et du matériel ayant rendus possibles ces changements s’estompent rapidement de la mémoire publique et professionnelle. […]

« Si l’on voulait être plus créatif [dans les années 1980], il n’était pas possible de simplement ajouter des logiciels à son système. Il fallait dépenser des centaines de milliers de dollars et s’acheter une Paintbox. Si l’on voulait faire quelque chose de graphique — une introduction d’émission télévisée avec beaucoup de calques —, il fallait aller chez un monteur et dépenser des centaines de dollars par heure pour faire exactement ce qu’on peut faire aujourd’hui en achetant un ordinateur bon marché et une poignée de logiciels. Aujourd’hui, avec Adobe After Effects et Photoshop, on peut tout faire d’un coup. On peut monter, concevoir, animer. On peut faire de la 2D et de la 3D, le tout chez soi sur son ordinateur ou dans de petits locaux44 Mindi Lipschultz, entretien avec The Compulsive Creative, mai 2004.. »

En 1989, les anciens pays satellites de l’URSS se libérèrent pacifiquement de son joug. Pour la Tchécoslovaquie, cet événement fut baptisé « Révolution de velours », en contraste avec les autres révolutions de l’histoire moderne qui se firent toujours dans le sang. Pour souligner le rythme progressif et presque invisible des transformations qui se jouèrent dans l’esthétique de l’image en mouvement entre 1993 et 1998 environ, je vais à mon tour emprunter ce terme de « Révolution de velours ». Bien qu’il puisse sembler présomptueux de comparer entre elles des transformations politiques et esthétiques simplement parce qu’elles partagent la même non-violence, en réalité — comme nous le verrons plus loin dans cet article — ces deux révolutions sont liées. […]

Bien que la Révolution de velours, dont je traiterai ici, ait impliqué de nombreux progrès technologiques et sociaux — matériel [hardware], logiciels [software], pratiques de production, nouveaux intitulés de poste et nouveaux champs professionnels — il convient de souligner qu’un package logiciel en particulier était au centre des événements : After Effects.

Créé en 1993, After Effects fut le premier logiciel conçu pour animer, composer et réaliser des effets spéciaux sur ordinateur personnel55 En réalité, NewTek Video Toaster, lancé en 1990, fut le premier système de production vidéo sur PC à inclure une table de mixage vidéo, la génération de personnages, la manipulation d’images et l’animation. En raison de son coût peu élevé, Video Toaster devint extrêmement populaire au cours des années 1990. Cependant, dans le contexte de mon article, After Effects est plus important, car comme je l’expliquerai plus loin, le programme introduisit un nouveau paradigme pour le design d’images en mouvement qui était différent du paradigme courant du montage vidéo soutenu par des systèmes tels que Toaster.. Son impact global sur la production peut être comparé à ceux qu’eurent Photoshop et Illustrator sur la photographie, l’illustration et le design graphique. Bien qu’aujourd’hui, les entreprises de media design et de postproduction continuent à s’appuyer sur des logiciels plus « haut de gamme » et plus onéreux, comme Flame, Inferno ou Paintbox […] ; After Effects reste l’application la plus appréciée et la plus connue dans ce domaine en raison de son prix abordable et de sa longue durée de vie. J’accorderai donc ici un rôle privilégié à After Effects, à la fois comme symbole et comme matériau-clef ayant permis la Révolution de velours dans la culture de l’image en mouvement — même si aujourd’hui, d’autres programmes dans la même gamme de prix, tels qu’Apple Motion, Autodesk Combustion ou Adobe Flash ont remis en cause l’hégémonie d’After Effects. […]

Exemples

L’utilisation d’After Effects est étroitement liée à un genre d’images en mouvement spécifique qui s’est répandu en grande partie en raison de ce logiciel : l’animation graphique (motion graphics). Définie de manière concise par Matt Frantz dans son mémoire de Master comme [un ensemble de] « visuels non narratifs et non figuratifs qui changent au fil du temps66 Matt Frantz, « Changing Over Time: The Future of Motion Graphics », 2003, http://b-o.fr/frantz », on retrouve l’animation graphique dans les titres de film et d’émissions télévisées, le graphisme télévisé, les menus dynamiques, le graphisme pour les contenus médias sur mobile et autres séquences animées. Elle représente typiquement une partie d’un tout plus large : publicités, clips, vidéo de formation, films documentaires ou narratifs, projets interactifs. Bien que l’animation graphique exemplifie clairement les changements qui eurent lieu au sein de la Révolution de velours, ces changements sont en fait plus profonds. Pour le dire simplement, le résultat de la Révolution de velours est un nouveau langage visuel hybride pour les images en mouvement en général. Ce langage ne se limite pas à certaines formes de médias et si aujourd’hui il se manifeste le plus clairement dans des formes non narratives, il est aussi souvent présent dans des séquences et des films narratifs et figuratifs.

Par exemple, les clips musicaux peuvent utiliser la prise de vue réelle tout en employant la typographie et une gamme de transitions réalisées en animation graphique  , ou le chanteur peut être incrusté dans un espace pictural animé

, ou le chanteur peut être incrusté dans un espace pictural animé  . Les courts-métrages peuvent mêler typographie, graphisme 3D stylisé, design animé et vidéo. Dans certains cas, la juxtaposition de différents médias est clairement perceptible

. Les courts-métrages peuvent mêler typographie, graphisme 3D stylisé, design animé et vidéo. Dans certains cas, la juxtaposition de différents médias est clairement perceptible  . Dans d’autres, une séquence peut se mouvoir entre différents médias si rapidement que les changements sont à peine visibles. Dans d’autres cas encore, une publicité ou un titre de film peuvent, par exemple, inclure des plans continus tournés en vidéo ou en pellicule, dont l’image alterne régulièrement entre un aspect naturel ou au contraire très stylisé. Si les solutions esthétiques individuelles varient selon les œuvres et les designers, elles partagent toutes la même logique : l’apparition simultanée de nombreux médias dans le même cadre. Que ces médias soient ouvertement superposés ou presque imperceptiblement fondus les uns dans les autres est moins important que cette coprésence elle-même.

. Dans d’autres, une séquence peut se mouvoir entre différents médias si rapidement que les changements sont à peine visibles. Dans d’autres cas encore, une publicité ou un titre de film peuvent, par exemple, inclure des plans continus tournés en vidéo ou en pellicule, dont l’image alterne régulièrement entre un aspect naturel ou au contraire très stylisé. Si les solutions esthétiques individuelles varient selon les œuvres et les designers, elles partagent toutes la même logique : l’apparition simultanée de nombreux médias dans le même cadre. Que ces médias soient ouvertement superposés ou presque imperceptiblement fondus les uns dans les autres est moins important que cette coprésence elle-même.

Aujourd’hui, ce langage visuel hybride est aussi partagé par une large proportion de courts-métrages « expérimentaux » (c’est-à-dire non commerciaux) produits pour des festivals, pour le Web, des appareils mobiles et autres plateformes de distribution. Un pourcentage élevé de visuels créés par les VJ et les artistes du Live Cinema sont également hybrides : ils associent vidéo, calques d’images 2D, animations et imagerie abstraite générée en temps réel. […] Dans le cas des longs-métrages narratifs au cinéma ou à la télévision, bien qu’ils ne mélangent encore que rarement différents styles graphiques au sein d’un même plan, nombre d’entre eux ont une esthétique extrêmement stylisée, que l’on identifiait autrefois davantage à l’illustration qu’à la réalisation — par exemple la série télévisée CSI, le dernier Star Wars de George Lucas ou Sin City  de Robert Rodriguez.

de Robert Rodriguez.

La remixabilité des médias

Quelle peut être la logique de ce nouveau langage visuel hybride ? C’est celle de la remixabilité : non seulement du contenu des différents médias, ni uniquement de leur esthétique, mais aussi de leurs techniques, de leurs méthodes de travail et de leurs postulats fondamentaux. Unis au sein d’un environnement logiciel commun, le cinéma, l’animation, l’animation par ordinateur, les effets spéciaux, le design graphique et la typographie forment à présent un nouveau metamedium. Un travail produit à travers ce nouveau métamédia peut utiliser toutes les technologies qui étaient autrefois spécifiques à chacun de ces médias, ou à tout sous-ensemble composé de ces techniques.

Si nous utilisions le concept de « remédiation » pour décrire cette nouvelle situation, nous déformerions cette logique — ou la logique du traitement informatique des médias en général77 Jay David Bolter et Richard Grusin, Remediation: Understanding New Media, Cambridge (MA), MIT Press, 1999.. L’ordinateur ne « remédie » pas à un média en particulier. Au contraire, il simule tous les médias et ce qu’il simule, ce ne sont pas leurs apparences de surface, mais toutes les techniques utilisées pour leur production, ainsi que les méthodes de visionnage et d’interaction avec les œuvres produites. Une fois que les différents types de médias se rencontrèrent au sein du même environnement numérique — et ce fut le cas à partir du milieu des années 1990 — leurs interactions prirent un tour qui aurait été imprévisible et même inimaginable auparavant. Par exemple, alors que certaines techniques continuent à être utilisées en relation avec leur support d’origine, elles peuvent aussi être appliquées à d’autres médias. Ce qui est rendu possible par la transformation des techniques en algorithmes et des médias eux-mêmes en données numériques stockées, sous la forme de fichiers compatibles et interopérables entre logiciels. Voici quelques exemples : on applique un effet de flou à des animations 3D numériques ; un champ de particules génératives se fond dans des séquences en prise de vue réelle pour la sublimer ; une caméra virtuelle se meut à travers un espace virtuel rempli de dessins 2D ; une typographie à plat est mise en mouvement, comme si elle était composée d’un matériau liquide (la simulation du liquide étant issue du champ de l’animation graphique), et ainsi de suite. Bien que cet usage du mélange constitue en lui-même un changement fondamental dans l’histoire des médias, aujourd’hui, un court-métrage ou une séquence typiques peuvent contenir un bon nombre de ces associations au sein d’un même plan. Le résultat est un langage visuel hybride, complexe et riche — ou plutôt, de nombreux langages qui partagent cette même logique de base de la remixabilité.

Je pense que la « remixabilité des médias » qui débute au milieu des années 1990 constitue une nouvelle étape fondamentale dans l’histoire des médias. Celle-ci se manifeste à travers différentes aires de la culture et pas seulement dans celle des images en mouvement — bien que celles-ci offrent un exemple particulièrement saisissant de la nouvelle logique mise en œuvre. Les logiciels tels que After Effects fonctionnent comme des boîtes de Petri où l’animation par ordinateur, le cinéma en prises de vues réelles, le design graphique, l’animation 2D et la typographie commencent à interagir, créant de nouveaux hybrides. Comme le démontrent les exemples ci-dessus, ce processus de remixabilité résulte en une nouvelle esthétique et une nouvelle forme de média et ne peut être réduite à la somme des médias qui la compose. En d’autres termes, les interactions entre différents médias dans le même environnement logiciel génèrent une nouvelle espèce culturelle.

La remixabilité ne mène pas nécessairement à une esthétique du collage marquée par la juxtaposition de divers médias et de leurs techniques. Pour un exemple très différent de ce que peut produire la remixabilité, examinons une esthétique plus subtile, qu’évoque bien le nom du logiciel que nous étudions ; After Effects. Si dans les années 1990, les ordinateurs servaient à créer des effets spéciaux spectaculaires ou des « effets invisibles », on vit autre chose émerger à la fin de la décennie : une nouvelle esthétique visuelle qui allait « au-delà des effets ». Dans cette esthétique, le projet dans son intégralité ; clip musical, publicité, court-métrage ou portion importante d’un long métrage — a un aspect hyper-réaliste. L’amélioration de plans issus de prises de vue réelles n’y est pas totalement invisible, sans pour autant attirer l’attention comme le faisaient généralement les effets spéciaux. Cette nouvelle esthétique hyper-réaliste représente un exemple supplémentaire de la manière dont, entre les mains des designers, la boîte de Petri du logiciel contenant tous les médias et toutes les techniques de maniement créées au cours de l’histoire humaine, produit à présent de nouveaux hybrides. D’ailleurs elle ne produit rien d’autre que des hybrides.

Calques, transparence et compositing

[…] Entre 1993 et 1998, le changement le plus spectaculaire fut sans doute la nouvelle capacité à associer de nombreux niveaux d’images aux degrés de transparence variés grâce au compositing numérique. Si l’on compare un clip ou une publicité télévisée typiques de 1986 avec leur équivalent de 1996, les différences sont frappantes (on peut en dire autant des images fixes). Comme je l’ai déjà noté, en 1986 les « banques de données informatisées » étaient très limitées dans leur capacité de stockage et leurs prix étaient prohibitifs ; ainsi, copier-coller de nombreuses images sources était rapidement problématique. Mais même en assemblant de multiples références visuelles, on ne pouvait que les placer côte à côte ou les superposer. Il était impossible de moduler ces juxtapositions en ajustant les niveaux de transparence des différentes images avec précision. Il fallait au contraire avoir recours aux techniques de photocollage ayant émergé dans les années 1920. […] En d’autres termes, le manque de transparence restreignait la quantité d’images sources différentes pouvant être intégrées dans une même composition, au risque que celle-ci ne commence à ressembler à l’un des photomontages de John Heartfield, Hannah Hoch ou Robert Rauschenberg — c’est-à-dire à une mosaïque de fragments sans dominante affirmée88 Dans le cas de la vidéo, combiner différents visuels posait également le problème de la dégradation rapide du signal lorsqu’une cassette analogique était copiée plusieurs fois. Ces copies ne correspondaient plus aux standards de diffusion..

Le compositing simplifia une autre opération qui auparavant était très fastidieuse. Jusque dans les années 1990, les différents types de médias, tels que l’animation à la main, les prises de vue réelles (pellicule ou numérique) et la typographie n’apparaissaient presque jamais dans les mêmes plans. En effet, les publicités animées, les courts-métrages publicitaires, les films industriels et certains longs-métrages ou films expérimentaux comprenant différents médias utilisaient généralement ces derniers dans des plans distincts. Quelques réalisateurs sont parvenus à construire des systèmes esthétiques à partir de ces superpositions temporelles — plus particulièrement Jean-Luc Godard. Dans ses films réalisés au cours des années 1960, tels que Week-end (1967), Godard intercala d’audacieuses compositions typographiques entre les plans en prises de vues réelles, créant ce que l’on pourrait appeler des « montages médias ». Dans les années 1960 toujours, le créateur pionnier du motion design Pablo Ferro, dont le nom de l’entreprise, Frame Imagery [Images cadres], était très à-propos, réalisa des courts-métrages promotionnels et du graphisme audiovisuel [TV graphics] qui jouaient sur la juxtaposition de différents médias se succédant à intervalles rapides99 Jeff Bellantfoni et Matt Woolman, Type in Motion, New York, Rizzoli, 1999, p. 22-29.. Dans bon nombre des spots de Ferro, les images fixes de lettrages, de dessins, d’œuvres peintes originales, de photographies, de brefs extraits tirés des actualités et autres visuels, se suivaient à un rythme très soutenu.

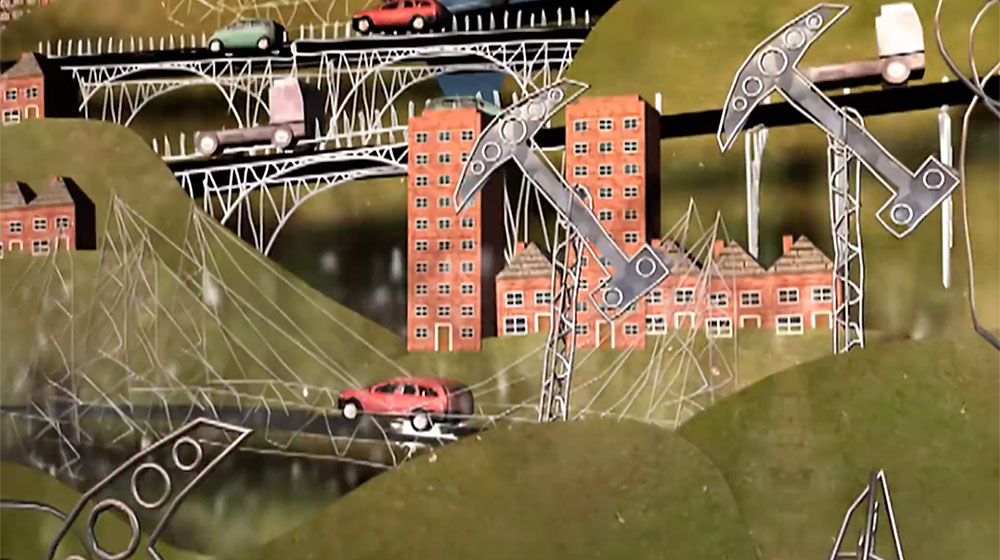

Au cinéma, la surimposition de différents médias au sein du même plan était généralement limitée à deux médias superposés de manière standardisée — les titres de longs-métrages apparaissant sous forme de lettres statiques apposées sur un plan en prise de vue réelle fixe ou en mouvement. Ferro et un autre pionnier, Saul Bass, créèrent plusieurs séquences de titres où les éléments visuels issus d’origines diverses étaient systématiquement superposés ensemble ; comme dans l’ouverture de Sueurs froides de Hitchcock, conçue par Bass (1958). Mais je crois qu’on peut affirmer sans crainte que des juxtapositions de médias aussi complexes au sein du même plan (plutôt que dans une même séquence montée) représentaient des exceptions dans un univers autrement « uni-média », où les images filmées apparaissaient dans les longs-métrages et les images dessinées à la main dans les films d’animation. Le seul réalisateur de longs-métrages du XXe siècle à avoir à ma connaissance bâti une esthétique unique par la combinaison systématique de différents médias dans le même plan est le Tchèque Karel Zeman. Un plan typique chez Zeman pouvait contenir des silhouettes humaines filmées, une vieille gravure utilisée comme arrière-plan, et une maquette miniature. […]

En des termes plus généraux, on peut affirmer qu’avant l’informatisation des années 1990, la capacité du designer à accéder à l’information visuelle, à la manipuler, la remixer et la filtrer, qu’elle soit fixe ou en mouvement, était assez limitée. Elle était en réalité pratiquement la même qu’un siècle plus tôt ; indépendamment du fait que les réalisateurs ou les designers utilisent des effets permis par la caméra, les procédés photomécaniques ou l’incrustation vidéo. A posteriori, on voit que ces possibilités étaient en décalage par rapport à la flexibilité, la rapidité et la précision de la manipulation de données déjà disponibles dans la plupart des autres domaines professionnels à avoir été informatisés ; les sciences, l’ingénierie, la comptabilité, le management, etc. Par conséquent, ce n’était qu’une question de temps avant que tous les médias visuels ne deviennent des données numériques et que les designers, les illustrateurs, les designers graphiques, les animateurs, les monteurs et les motion designers ne commencent à les manier à l’aide de logiciels plutôt qu’avec leurs outils traditionnels. Mais cela n’a été rendu évident qu’aujourd’hui, après la Révolution de velours.

En 1985, Jeff Stein réalisa un clip pour le groupe de new wave The Cars. Ce clip  connut un large écho dans le monde du design et MTV lui décerna le premier MTV Music Award pour la meilleure vidéo de l’année. Stein y figurait un monde surréaliste dans lequel une vidéo découpée représentant la tête du chanteur apparaissait sur différents fonds animés. Stein emprunta l’esthétique des dessins animés (un personnage animé en 2D surimposé sur un fond 2D), pour la recréer à l’aide d’images vidéo. […] Soudain, le photomontage moderniste prenait vie. Mais dix ans plus tard, ces collages vidéo en mouvement devinrent non seulement plus courants, mais aussi plus complexes, plus stratifiés et plus subtils. Plutôt que deux ou trois calques, la composition pouvait contenir des centaines ou des milliers de couches d’images, chacune avec son propre niveau de transparence.

connut un large écho dans le monde du design et MTV lui décerna le premier MTV Music Award pour la meilleure vidéo de l’année. Stein y figurait un monde surréaliste dans lequel une vidéo découpée représentant la tête du chanteur apparaissait sur différents fonds animés. Stein emprunta l’esthétique des dessins animés (un personnage animé en 2D surimposé sur un fond 2D), pour la recréer à l’aide d’images vidéo. […] Soudain, le photomontage moderniste prenait vie. Mais dix ans plus tard, ces collages vidéo en mouvement devinrent non seulement plus courants, mais aussi plus complexes, plus stratifiés et plus subtils. Plutôt que deux ou trois calques, la composition pouvait contenir des centaines ou des milliers de couches d’images, chacune avec son propre niveau de transparence.

En somme, le compositing numérique permettait à présent aux créateurs de mélanger autant d’éléments visuels qu’ils ou elles le désiraient, sans tenir compte de leur média d’origine, et de contrôler chaque élément de ce processus. Il est ainsi possible d’établir un parallèle entre les enregistrements audio multipistes et le compositing des images en mouvement. Dans les enregistrements multipistes, chacune peut être manipulée individuellement pour produire le résultat escompté. De même, chaque élément visuel peut être modulé indépendamment et de diverses manières : redimensionné, recolorisé, animé, etc. […] Tout comme l’enregistrement multipiste redéfinit le son de la musique populaire à partir des années 1960, une fois que le compositing devint largement disponible au cours des années 1990, l’esthétique visuelle des images en mouvements dans la culture populaire s’en trouva modifiée. […]

À la fin des années 1990, le compositing numérique était devenu une opération de base, utilisée pour créer toutes les formes d’images en mouvement, et plus seulement les films à gros budgets. Ainsi, bien qu’il ait originellement été développé dans le contexte de la production d’effets spéciaux dans les années 1970 et au début des années 19801010 Thomas Porter et Tom Duff, « Compositing Digital Images », ACM Computer Graphics, vol. 18, no 3, 1984, p. 253-259., il eut un effet beaucoup plus important sur les cultures visuelles et médiatiques contemporaines. Le compositing joua un rôle clef dans la transformation de l’ordinateur numérique en laboratoire expérimental, rendant possible la rencontre de différents médias dont l’esthétique et les techniques pouvaient être associées afin de créer de nouveaux objets. […]

Ainsi, le compositing, une technique numérique spécifiquement conçue pour associer la prise de vue réelle et le graphisme informatisé, devint un « intégrateur de média universel ». Bien qu’il ait d’abord été conçu pour soutenir l’esthétique du réalisme cinématographique, il commença au fil du temps à avoir un effet contraire. Plutôt que d’obliger les différents médias à fusionner de manière fluide, le compositing mena à la multiplication de nombreux médias hybrides, où les juxtapositions entre la prise de vue réelle ou générée par algorithme, entre le bi- et le tridimensionnel, le matriciel et le vectoriel, étaient rendus délibérément visibles plutôt que d’être dissimulés.

De la temporalité à la composition

Ma thèse sur la remixabilité des médias s’applique aussi bien aux formes culturelles qu’aux logiciels utilisés pour les créer. Tout comme les images en mouvement réalisées aujourd’hui par des designers mélangent les formats, les hypothèses et les techniques de différents médias, les boîtes à outils et les interfaces utilisées par les logiciels sont elles aussi des remix. […] Lorsque les motion designers commencent à utiliser les logiciels de compositing et d’animation tels qu’After Effects, l’interface elle-même les pousse à penser l’image en mouvement d’une manière radicalement nouvelle. Les systèmes de montage pour pellicule et vidéo, ainsi que leurs simulations sur ordinateur, que l’on appelle systèmes de montage non linéaires (comme Avid et Final Cut1111 Il faut noter que la fonctionnalité de compositing fut progressivement ajoutée à la plupart des systèmes de montage non linéaire, si bien que la distinction entre l’interface des premiers temps chez After Effects ou Flame d’une part, et Avid et Final Cut de l’autre, est moins prononcée. aujourd’hui) ont conceptualisé les projets comme des séquences de plans organisés dans le temps. Par conséquent, bien que la plupart des systèmes de montage non linéaire aient offert aux monteurs de nombreux outils, la continuité du langage filmique issu de son organisation industrielle allait de soi : toutes les vues ont la même échelle et les mêmes proportions. Cet exemple renvoie à un phénomène plus large : alors que les médias physiques étaient simulés par ordinateur, bien souvent, nombre de leurs propriétés fondamentales, des conventions de leur interface et de leurs contraintes furent méthodiquement recréées par le logiciel — même si le média du logiciel lui-même n’était limité par aucune de ces restrictions. Par contraste, depuis le début, l’interface After Effects mit en avant une nouvelle conception de l’image en mouvement : une composition organisée dans le temps et l’espace 2D.

Cette interface est structurée autour de la fenêtre Composition, conceptualisée comme un grand canevas qui peut contenir des éléments visuels de tailles et de proportions arbitraires. Lorsque je commençai à utiliser After Effects peu après sa sortie, je me souviens m’être senti très surpris que le logiciel ne redimensionnât pas automatiquement les images que je déposais dans la fenêtre Composition afin de les faire tenir dans le plan. Le postulat fondamental du cinéma, qui accompagne ce média depuis le début de son histoire — à savoir que le film est constitué de plusieurs plans du même format — avait disparu.

Dans les paradigmes du montage de film et de vidéos, l’unité minimale avec laquelle travaille le monteur est le plan. Il est possible de changer la longueur d’un montage, en ajustant le début ou la fin d’un segment, mais le monteur ne peut pas intervenir sur le contenu des plans. […] C’était là le travail du département des effets spéciaux. Mais dans l’interface d’After Effects, l’unité de base n’est pas un plan, mais un élément visuel placé dans la fenêtre Composition. On peut accéder individuellement à chaque élément, le manier et l’animer […]. Il est considéré comme un objet indépendant. Par conséquent, une composition média est considérée comme un ensemble d’objets indépendants qui peuvent changer dans le temps. Le terme de « composition » lui-même est important dans ce contexte, car il fait référence au média 2D (dessin, peinture, photographie, design) plutôt qu’au cinéma — en d’autres termes, à l’espace plutôt qu’au temps.

D’où vient l’interface d’After Effects ? Étant donné que ce logiciel est communément utilisé pour créer des graphismes animés ou des effets visuels, il n’est pas étonnant de pouvoir retrouver dans l’interface certains éléments qui peuvent être reliés à trois champs différents : l’animation, le design graphique et les effets spéciaux. Dans la pratique traditionnelle de l’animation, l’animateur superpose un certain nombre de celluloïds. Chaque celluloïd contient un dessin différent : le corps d’un personnage sur un premier, la tête sur un autre, les yeux sur le troisième. Comme les celluloïds sont transparents, les dessins sont automatiquement « composés » en un ensemble unique. Bien que l’interface d’After Effects n’utilise pas directement la métaphore de l’empilement de celluloïds transparents, elle est basée sur le même principe. À chaque élément de la fenêtre Composition correspond une « profondeur virtuelle » relative à tous les autres éléments. Tous ensemble, ils forment un empilement virtuel. À tout moment, le designer peut changer la position relative de tel ou tel élément au sein de l’empilement, le supprimer, ou ajouter de nouveaux éléments. […] Ces derniers peuvent être un plan vidéo numérique, une ligne de caractères, une forme géométrique arbitraire, etc. Le résultat final correspond à l’agencement particulier de ces éléments dans le temps et l’espace. Au sein de ce paradigme, on peut comparer le designer à un chorégraphe qui crée une danse en « animant » le corps des danseurs — il définit le moment de leurs entrées et de leurs sorties, leurs trajectoires à travers l’espace scénique et le mouvement de leurs corps. De ce point de vue, on notera que bien que l’interface d’After Effects n’évoque pas cette référence, alors que Macromedia Director, l’un des logiciels de création multimédia les plus importants depuis les années 1990, utilise, lui, la métaphore de la scène théâtrale.

Bien que l’on puisse rattacher l’interface d’After Effects aux méthodes utilisées par les studios d’animation traditionnelle, la méthode de travail mise en avant par le logiciel est plus proche du design graphique. […] Un designer graphique travaille « en temps réel » : au fur et à mesure qu’il introduit de nouveaux éléments, ajuste leur place, leurs couleurs ou encore d’autres propriétés, qu’il essaye différentes images, modifiant le corps des caractères, et ainsi de suite, il peut immédiatement percevoir le résultat de son travail. […] Lorsque des médias physiques sont simulés par ordinateur, le résultat n’est pas simplement le média d’origine. En ajoutant de nouvelles propriétés et de nouvelles méthodes de travail, la simulation informatique change fondamentalement l’identité d’un média donné. Par exemple, dans le cas du « papier électronique », tel qu’on le retrouve dans un document Word ou un fichier PDF, on peut réaliser de nombreuses actions impossibles à faire avec du papier ordinaire : zoomer ou dézoomer dans le document, chercher une phrase particulière, changer l’alphabet et l’interlignage, etc. De même, les services de cartes interactives en ligne aujourd’hui (en 2006), fournis par MapQuest, Yahoo et Google, augmentent la carte papier traditionnelle de façon considérable et tout à fait extraordinaire ; il suffit de regarder Google Earth.

Une proportion significative des logiciels contemporains servant à créer, monter et interagir avec les médias se sont développés de cette manière ; en simulant les médias physiques et en les augmentant de nouvelles propriétés. Mais si l’on considère les logiciels de media design tels que Maya (utilisé pour la modélisation 3D et l’animation par ordinateur) ou After Effects (animation graphique, compositing et effets visuels), on se confronte à une logique différente. Ces applications ne simulent aucun média physique préexistant. Au contraire, elles empruntent à divers médias qui combinent et mêlent leurs méthodes de travail et leurs techniques spécifiques et ajoutent évidemment de nouvelles possibilités qui sont spécifiques à l’ordinateur — comme le calcul automatique des valeurs intermédiaires entre diverses images-clefs. […]

Le résultat n’est pas simplement la somme mécanique de tous les éléments venant d’un média antérieur. Ainsi, quand le logiciel remixe les techniques et les méthodes de travail des différents médias qu’il simule, il crée de nouvelles interfaces, de nouveaux outils et de nouvelles capacités de travail avec leur propre logique. Dans le cas d’After Effects, la méthode de travail mise en avant n’est ni l’animation, ni le design graphique, ni le cinéma, même si elle puise dans chacun de ces champs. […]

La Révolution de velours déclenchée notamment par After Effects ne rendit pas simplement plus familière l’animation que des artistes et des designers (dont John et James Whitney, Norman McLaren, Saul Bass, Robert Abel, Harry Marks et R/Greenberg) pratiquaient auparavant en utilisant l’animation image par image, l’impression optique, les effets vidéo, le matériel des années 1980 ou des procédés maison. En effet, cette révolution mena à l’émergence de nombreuses nouvelles esthétiques visuelles qui n’existaient pas auparavant et d’une nouvelle manière de produire des images en mouvement. […]

Ce texte est une traduction inédite de la première partie de l’essai « After Effects, or Velvet Revolution », initialement publié en 2006 dans Millenium Film Journal (no 45-46).